AI MAX-概述

AI Max 是 AMAX一款基于 Kubernetes+Docker+GPU 架构,定位于机器学习的上层应用,免去客户编写代码的麻烦,快速开始深度学习任务的平台。软件基于容器基础,内置多种深度学习框架,兼具细粒度的权限管控,完善的数据与镜像的存储、隔离,提供多种交互式开发及 API 接口,可满足多用户、多场景的需求。

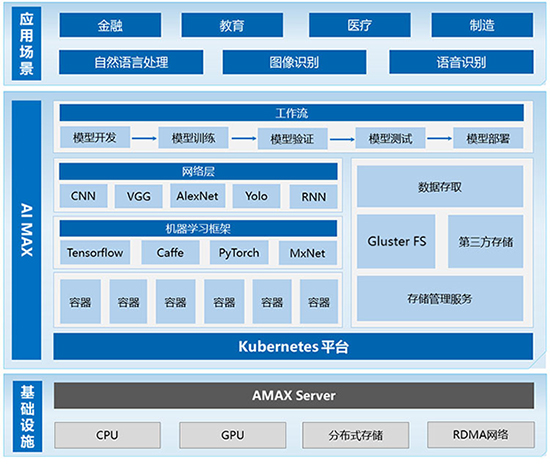

架构介绍

基础层

基础设施以硬件服务器为载体,支持主流 X86 服务器,配置 NVIDIA GPU 实现高性能加速计算,采用主流分布式存储设备(如:XP-42305ST ),支持 TCP/IP,InfiniBand 高速网络互联。

AI Max 平台层

平台层是整个系统的核心,包含操作系统、GPU 驱动、CUDA、CuDNN、机器学习框架、资源调度和完整的机器学习所需的处理流程,实现资源操作自动化,并向用户提供应用交付服务。

AI MAX-特点与优势

架构介绍

表盘式工作界面,从首页可以看到,AI Max 集群里所有的资源,已分配的资源,所有的计算节点信息、任务信息等。菜单界面平滑直观,所有功能一目了然。用户界面下,UI界面平滑直观,所有项目一目了然,菜单选项简洁明了,功能化繁为简。

管理员界面下,针对用户组或用户进行便捷的操作管理,灵活支配计算机资源;完整记录用户详细适用信息。

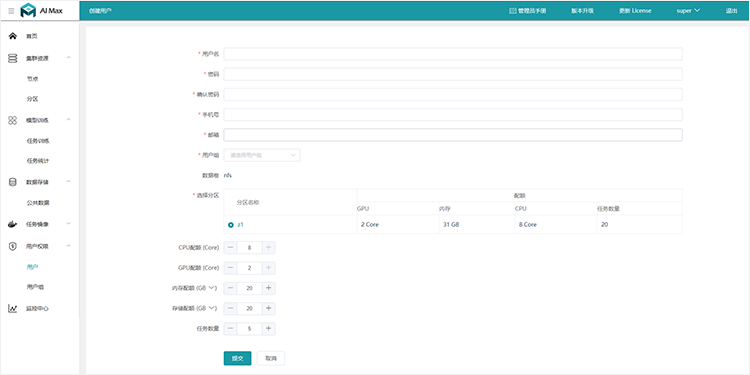

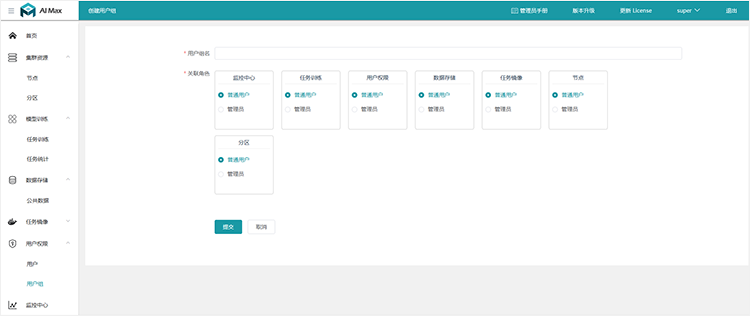

用户权限管理

管理员可通过用户管理对用户进行细粒度管理,对用户或用户组进行增删改查等操作。亦可根据不用的场景、应用需求设置不同的用户权限,以达到细致的安全控制。

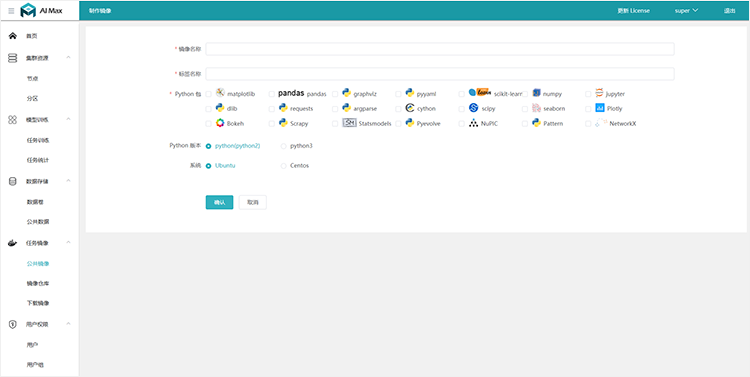

镜像管理

系统预置种类丰富的任务镜像,支持各种机器学习框架,如:Caffe、TensorFlow、MxNET、Pytorch等。

用户可通过基础镜像与 Docker exec console 制作镜像保存到镜像仓库,公共镜像和私人镜像相互隔离,启动快速且不干扰。

用户使用时只需自定义资源配额( CPU、内存、GPU 等),选择训练框架并根据需求做出相应调整。

镜像制作允许用户自定义 python package,可支持本地环境 pull 和 push 镜像。

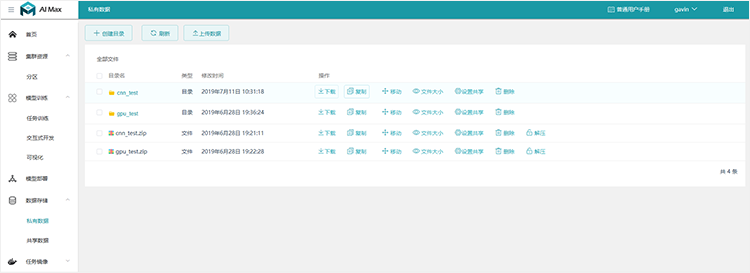

数据存储

基于 Gluster 的分布式存储架构,存储容量大、容易横向扩展,各用户自动创建指定配额的存储用于存放训练数据集、测试数据集、训练结果等。支持创建私有数据,支持把私有数据共享给组和用户,支持取消共享。

分布式存储网络支持 IB 和 RDMA,保证大规模网络训练时的网络带宽,提高训练的效率。分布式、冗余及数据条带化,满足不同用户对数据的安全和性能要求。丰富的数据管理、分享功能极大方便了用户的使用。

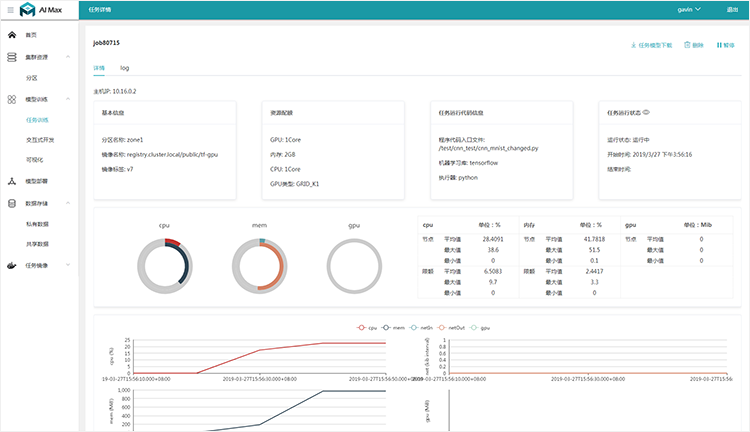

模型训练

基于 Kubernetes 的容器调度引擎,支持离线训练,成熟稳定;支持 TensorFlow 框架的多机多卡分布式训练,可通过 key-value 对的形式设置超参数;任务训练时,支持可视化及显示 loss 和 accuracy 变化曲线,可实时查看任务训练过程中的 log 输出;可动态调度任务到优质的节点上,保证资源使用的效率;同时支持 Jupyter,JupyterLab,PyCharm,Terminal 等多种交互式开发方式和调试。

模型训练、超参数调节、模型可视化、日志查看等一系列环节和工具,使用户可以聚焦在核心的算法设计上面,极大提高了工作效率。通过资源配额、任务调度和容错,使模型训练任务高效可靠;分布式任务使大规模网络模型的训练性能大大提高。

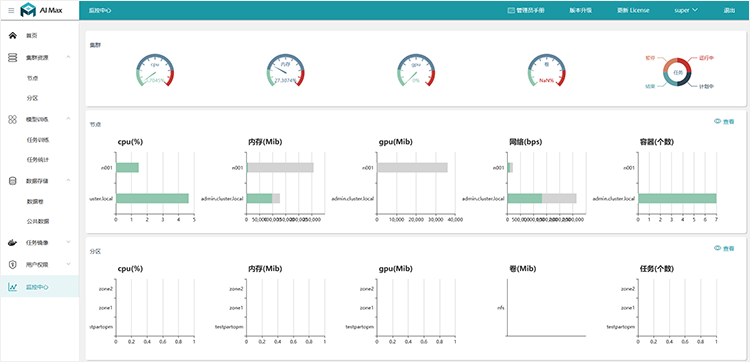

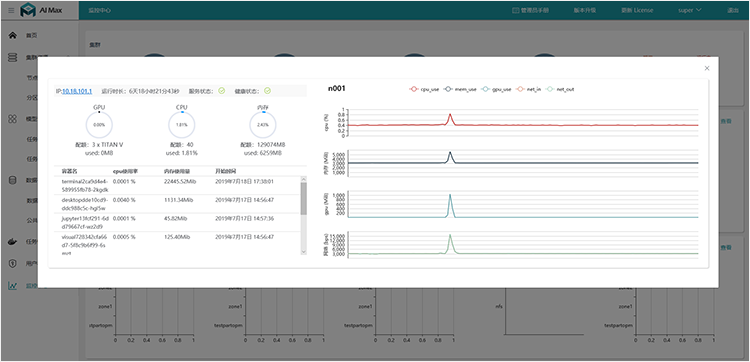

集群管理

集群节点添加、删除,可支持节点资源使用监控、节点远程开关机、节点健康状态监控,同时具备节点远程控制台;用户可通过远程控制台监控机器健康状态和资源使用情况;使用直方图显示节点和分区CPU、GPU、Mem、网络IO、运行容器数量的实时统计;可显示任务GPU显存使用率。

总结

人工智能现已成为非常火热的话题,众多院校纷纷开启人工智能专业课程,各企业也纷纷涉猎人工智能领域。深度学习是实现人工智能中重要的一环,但深度学习环境的部署极其复杂,众多的深度学习框架、神经网络模型、GPU 卡片类型等的选择都具有一定难度。

AI Max 深度学习平台,可解决图像处理、语音识别、自然语言处理等深度学习场景下,不同算法模型、深度学习框架的 GPU 计算资源和存储资源的统一调度和管理,合理分配不同用户使用。AI Max 深度学习平台支持多种深度学习框架,利用容器技术将大量的底层操作进行封装,极大的简化了深度学习的操作流程,大大降低了深度学习从业人员的技术门槛,让用户更聚焦业务本身,是 AI 业务能快速开发和上线。

同时 AI Max 在设计中整合了计算、存储和网络资源,把负责提供计算能力的硬件自身包含的存储能力优化挖掘并应用起来,免去传统集群环境下存储的规划、连接、配置等复杂的管理操作,无需再配置 Raid 组、LUN、卷等。客户可通过 AI Max 可以灵活高效地实现节点拓展,来增加资源以满足业务的增长。